创建基于管理器的基础环境#

环境将仿真的不同方面,如场景、观测和行动空间、重置事件等集合在一起,为各种应用程序创建一个连贯的接口。在Isaac Lab中,基于管理器的环境被实现为: envs.ManagerBasedEnv 和 envs.ManagerBasedRLEnv 类。这两个类非常相似,但 envs.ManagerBasedRLEnv 对强化学习任务很有用,并包含奖励、中止、课程表和命令生成。 envs.ManagerBasedEnv 类适用于传统的机器人控制,不包含奖励和中止条件。

在本教程中,我们将研究基础类:envs.ManagerBasedEnv 及其对应的配置类:envs.ManagerBasedEnvCfg ,用于基于管理器的工作流程。我们将使用之前的cartpole环境来说明创建新的 envs.ManagerBasedEnv 环境中的不同组件。

代码#

此教程对应于 scripts/tutorials/03_envs 目录中的 create_cartpole_base_env 脚本。

create_cartpole_base_env.py的代码

1# Copyright (c) 2022-2026, The Isaac Lab Project Developers (https://github.com/isaac-sim/IsaacLab/blob/main/CONTRIBUTORS.md).

2# All rights reserved.

3#

4# SPDX-License-Identifier: BSD-3-Clause

5

6"""

7This script demonstrates how to create a simple environment with a cartpole. It combines the concepts of

8scene, action, observation and event managers to create an environment.

9

10.. code-block:: bash

11

12 ./isaaclab.sh -p scripts/tutorials/03_envs/create_cartpole_base_env.py --num_envs 32

13

14"""

15

16"""Launch Isaac Sim Simulator first."""

17

18

19import argparse

20

21from isaaclab.app import AppLauncher

22

23# add argparse arguments

24parser = argparse.ArgumentParser(description="Tutorial on creating a cartpole base environment.")

25parser.add_argument("--num_envs", type=int, default=16, help="Number of environments to spawn.")

26

27# append AppLauncher cli args

28AppLauncher.add_app_launcher_args(parser)

29# parse the arguments

30args_cli = parser.parse_args()

31

32# launch omniverse app

33app_launcher = AppLauncher(args_cli)

34simulation_app = app_launcher.app

35

36"""Rest everything follows."""

37

38import math

39

40import torch

41

42import isaaclab.envs.mdp as mdp

43from isaaclab.envs import ManagerBasedEnv, ManagerBasedEnvCfg

44from isaaclab.managers import EventTermCfg as EventTerm

45from isaaclab.managers import ObservationGroupCfg as ObsGroup

46from isaaclab.managers import ObservationTermCfg as ObsTerm

47from isaaclab.managers import SceneEntityCfg

48from isaaclab.utils import configclass

49

50from isaaclab_tasks.manager_based.classic.cartpole.cartpole_env_cfg import CartpoleSceneCfg

51

52

53@configclass

54class ActionsCfg:

55 """Action specifications for the environment."""

56

57 joint_efforts = mdp.JointEffortActionCfg(asset_name="robot", joint_names=["slider_to_cart"], scale=5.0)

58

59

60@configclass

61class ObservationsCfg:

62 """Observation specifications for the environment."""

63

64 @configclass

65 class PolicyCfg(ObsGroup):

66 """Observations for policy group."""

67

68 # observation terms (order preserved)

69 joint_pos_rel = ObsTerm(func=mdp.joint_pos_rel)

70 joint_vel_rel = ObsTerm(func=mdp.joint_vel_rel)

71

72 def __post_init__(self) -> None:

73 self.enable_corruption = False

74 self.concatenate_terms = True

75

76 # observation groups

77 policy: PolicyCfg = PolicyCfg()

78

79

80@configclass

81class EventCfg:

82 """Configuration for events."""

83

84 # on startup

85 add_pole_mass = EventTerm(

86 func=mdp.randomize_rigid_body_mass,

87 mode="startup",

88 params={

89 "asset_cfg": SceneEntityCfg("robot", body_names=["pole"]),

90 "mass_distribution_params": (0.1, 0.5),

91 "operation": "add",

92 },

93 )

94

95 # on reset

96 reset_cart_position = EventTerm(

97 func=mdp.reset_joints_by_offset,

98 mode="reset",

99 params={

100 "asset_cfg": SceneEntityCfg("robot", joint_names=["slider_to_cart"]),

101 "position_range": (-1.0, 1.0),

102 "velocity_range": (-0.1, 0.1),

103 },

104 )

105

106 reset_pole_position = EventTerm(

107 func=mdp.reset_joints_by_offset,

108 mode="reset",

109 params={

110 "asset_cfg": SceneEntityCfg("robot", joint_names=["cart_to_pole"]),

111 "position_range": (-0.125 * math.pi, 0.125 * math.pi),

112 "velocity_range": (-0.01 * math.pi, 0.01 * math.pi),

113 },

114 )

115

116

117@configclass

118class CartpoleEnvCfg(ManagerBasedEnvCfg):

119 """Configuration for the cartpole environment."""

120

121 # Scene settings

122 scene = CartpoleSceneCfg(num_envs=1024, env_spacing=2.5)

123 # Basic settings

124 observations = ObservationsCfg()

125 actions = ActionsCfg()

126 events = EventCfg()

127

128 def __post_init__(self):

129 """Post initialization."""

130 # viewer settings

131 self.viewer.eye = [4.5, 0.0, 6.0]

132 self.viewer.lookat = [0.0, 0.0, 2.0]

133 # step settings

134 self.decimation = 4 # env step every 4 sim steps: 200Hz / 4 = 50Hz

135 # simulation settings

136 self.sim.dt = 0.005 # sim step every 5ms: 200Hz

137

138

139def main():

140 """Main function."""

141 # parse the arguments

142 env_cfg = CartpoleEnvCfg()

143 env_cfg.scene.num_envs = args_cli.num_envs

144 env_cfg.sim.device = args_cli.device

145 # setup base environment

146 env = ManagerBasedEnv(cfg=env_cfg)

147

148 # simulate physics

149 count = 0

150 while simulation_app.is_running():

151 with torch.inference_mode():

152 # reset

153 if count % 300 == 0:

154 count = 0

155 env.reset()

156 print("-" * 80)

157 print("[INFO]: Resetting environment...")

158 # sample random actions

159 joint_efforts = torch.randn_like(env.action_manager.action)

160 # step the environment

161 obs, _ = env.step(joint_efforts)

162 # print current orientation of pole

163 print("[Env 0]: Pole joint: ", obs["policy"][0][1].item())

164 # update counter

165 count += 1

166

167 # close the environment

168 env.close()

169

170

171if __name__ == "__main__":

172 # run the main function

173 main()

174 # close sim app

175 simulation_app.close()

代码解释#

envs.ManagerBasedEnv 基类包含了仿真交互的许多复杂性,并为用户提供了一个简单的接口来运行仿真并与其交互。它由以下组件组成:

scene.InteractiveScene- 用于仿真的场景。managers.ActionManager- 处理动作的管理器。managers.ObservationManager- 处理观测的管理器。managers.EventManager- 安排操作(例如域随机化)在指定的仿真事件上执行。例如,启动时,重置时或定期间隔。

通过配置这些组件,用户可以以最小的工作量创建相同环境的不同变体。在本教程中,我们将浏览 envs.ManagerBasedEnv 类的不同组件以及如何配置它们来创建新环境。

设计场景#

创建新环境的第一步是配置其场景。对于cartpole环境,我们将使用前一个教程中的场景。因此,我们在这里省略场景配置。有关如何配置场景的更多详细信息,请参阅: 使用交互式场景 。

定义actions#

在前一个教程中,我们直接使用 assets.Articulation.set_joint_effort_target() 方法对cartpole进行动作控制。在本教程中,我们将使用 managers.ActionManager 来处理这些actions。

动作管理器可以包括多个 managers.ActionTerm 。每个动作项负责对环境的特定方面进行*控制* 。例如,对于机器人手臂,我们可以有两个动作项--一个用于控制手臂的关节,另一个用于控制夹爪。这种组合允许用户为环境的不同方面定义不同的控制方案。

在cartpole环境中,我们希望控制施加在小车上的力以平衡杆。因此,我们将创建一个动作项来控制施加在小车上的力。

@configclass

class ActionsCfg:

"""Action specifications for the environment."""

joint_efforts = mdp.JointEffortActionCfg(asset_name="robot", joint_names=["slider_to_cart"], scale=5.0)

定义观测#

虽然场景定义了环境的状态,但观测定义了智能体可以观察到的状态。智能体使用这些观测来决定采取什么行动。在Isaac Lab中,观测由 managers.ObservationManager 类计算。

与动作管理器类似,观测管理器可以包含多个观测项。这些进一步分组为观测组,用于定义环境的不同观测空间。例如,对于分层控制,我们可能想定义两个观测组--一个用于低级控制器,另一个用于高级控制器。这些项假定在组中的所有观测项具有相同的维度。

对于本教程,我们只定义了一个名为 "policy" 的观测组。虽然不是完全具体的,但这个组对于Isaac Lab中的各种包装来说是一个必要的要求。我们通过继承 managers.ObservationGroupCfg 类来定义一个组。这个类收集不同的观测项,并帮助定义组的公共属性,比如启用噪声损坏或将观测项连接成一个张量。

通过继承 managers.ObservationTermCfg 类来定义单独的项。这个类采用了 managers.ObservationTermCfg.func ,它指定了用于计算该项观测的函数或可调用类。它包括用于定义噪声模型、剪切、缩放等的其他参数。然而,对于本教程,我们将这些参数保留为其默认值。

@configclass

class ObservationsCfg:

"""Observation specifications for the environment."""

@configclass

class PolicyCfg(ObsGroup):

"""Observations for policy group."""

# observation terms (order preserved)

joint_pos_rel = ObsTerm(func=mdp.joint_pos_rel)

joint_vel_rel = ObsTerm(func=mdp.joint_vel_rel)

def __post_init__(self) -> None:

self.enable_corruption = False

self.concatenate_terms = True

# observation groups

policy: PolicyCfg = PolicyCfg()

定义事件#

此时,我们已经为cartpole环境定义了场景、动作和观测。所有这些组件的一般思想是定义配置类,然后将它们传递给相应的管理器。事件管理器也不例外。

managers.EventManager 类负责对应于仿真状态的更改的事件。这包括重置(或随机化)场景、随机化物理特性(如质量、摩擦等)以及改变视觉特性(如颜色、纹理等)。每个事件都通过 managers.EventTermCfg 类来指定,该类采用 managers.EventTermCfg.func 来指定执行事件的函数或可调用类。

此外,它期望事件的 模式 。这个模式指定事件项应何时应用。可以指定自己的模式。为此,您需要调整 ManagerBasedEnv 类。但是,Isaac Lab提供了三种常用的模式:

"启动(startup)"- 仅在环境启动时发生的事件。"重置(reset)"- 当环境终止和重置时发生的事件。"间隔(interval)"- 在给定间隔后执行的事件,即每隔一定步数之后。

对于此示例,我们定义了在启动时随机化杆的质量的事件。这只发生一次,因为此操作很昂贵,我们不希望在每次重置时都进行。我们还创建了一个事件,以在每次重置时随机化小车和杆的初始关节状态。

@configclass

class EventCfg:

"""Configuration for events."""

# on startup

add_pole_mass = EventTerm(

func=mdp.randomize_rigid_body_mass,

mode="startup",

params={

"asset_cfg": SceneEntityCfg("robot", body_names=["pole"]),

"mass_distribution_params": (0.1, 0.5),

"operation": "add",

},

)

# on reset

reset_cart_position = EventTerm(

func=mdp.reset_joints_by_offset,

mode="reset",

params={

"asset_cfg": SceneEntityCfg("robot", joint_names=["slider_to_cart"]),

"position_range": (-1.0, 1.0),

"velocity_range": (-0.1, 0.1),

},

)

reset_pole_position = EventTerm(

func=mdp.reset_joints_by_offset,

mode="reset",

params={

"asset_cfg": SceneEntityCfg("robot", joint_names=["cart_to_pole"]),

"position_range": (-0.125 * math.pi, 0.125 * math.pi),

"velocity_range": (-0.01 * math.pi, 0.01 * math.pi),

},

)

将所有这些组件组合在一起#

定义了场景和管理器配置之后,我们现在可以通过 envs.ManagerBasedEnvCfg 类定义环境配置。这个类接受场景、动作、观测和事件配置。

除此之外,它还接收了 envs.ManagerBasedEnvCfg.sim ,它定义了仿真参数,如时间步长、重力等。这些参数被初始化为默认值,但可以根据需要进行修改。我们建议通过在 envs.ManagerBasedEnvCfg 类中定义 __post_init__() 方法来实现,该方法在配置初始化后被调用。

@configclass

class CartpoleEnvCfg(ManagerBasedEnvCfg):

"""Configuration for the cartpole environment."""

# Scene settings

scene = CartpoleSceneCfg(num_envs=1024, env_spacing=2.5)

# Basic settings

observations = ObservationsCfg()

actions = ActionsCfg()

events = EventCfg()

def __post_init__(self):

"""Post initialization."""

# viewer settings

self.viewer.eye = [4.5, 0.0, 6.0]

self.viewer.lookat = [0.0, 0.0, 2.0]

# step settings

self.decimation = 4 # env step every 4 sim steps: 200Hz / 4 = 50Hz

# simulation settings

self.sim.dt = 0.005 # sim step every 5ms: 200Hz

运行仿真#

最后,我们再次访问仿真执行循环。现在,这非常简单,因为我们已经抽象出大部分细节到环境配置中。我们只需要调用 envs.ManagerBasedEnv.reset() 方法来重置环境,以及在 envs.ManagerBasedEnv.step() 方法中步进环境。这两个函数都会返回观测和信息字典,后者可能包含环境提供的其他信息。智能体可以使用这些信息做决策。

envs.ManagerBasedEnv 类没有任何中止概念,因为该概念对于周期性任务是特定的。因此,用户需要负责为环境定义终止条件。在本教程中,我们定期重置仿真。

def main():

"""Main function."""

# parse the arguments

env_cfg = CartpoleEnvCfg()

env_cfg.scene.num_envs = args_cli.num_envs

env_cfg.sim.device = args_cli.device

# setup base environment

env = ManagerBasedEnv(cfg=env_cfg)

# simulate physics

count = 0

while simulation_app.is_running():

with torch.inference_mode():

# reset

if count % 300 == 0:

count = 0

env.reset()

print("-" * 80)

print("[INFO]: Resetting environment...")

# sample random actions

joint_efforts = torch.randn_like(env.action_manager.action)

# step the environment

obs, _ = env.step(joint_efforts)

# print current orientation of pole

print("[Env 0]: Pole joint: ", obs["policy"][0][1].item())

# update counter

count += 1

# close the environment

env.close()

上面需要注意的一个重要事项是整个仿真循环包含在 torch.inference_mode() 上下文管理器中。这是因为环境在幕后使用PyTorch操作,我们希望确保仿真不会因PyTorch的自动求导引擎的开销而变慢,也不会为仿真操作计算梯度。

代码执行#

运行此教程中创建的基本环境,您可以使用以下命令:

./isaaclab.sh -p scripts/tutorials/03_envs/create_cartpole_base_env.py --num_envs 32

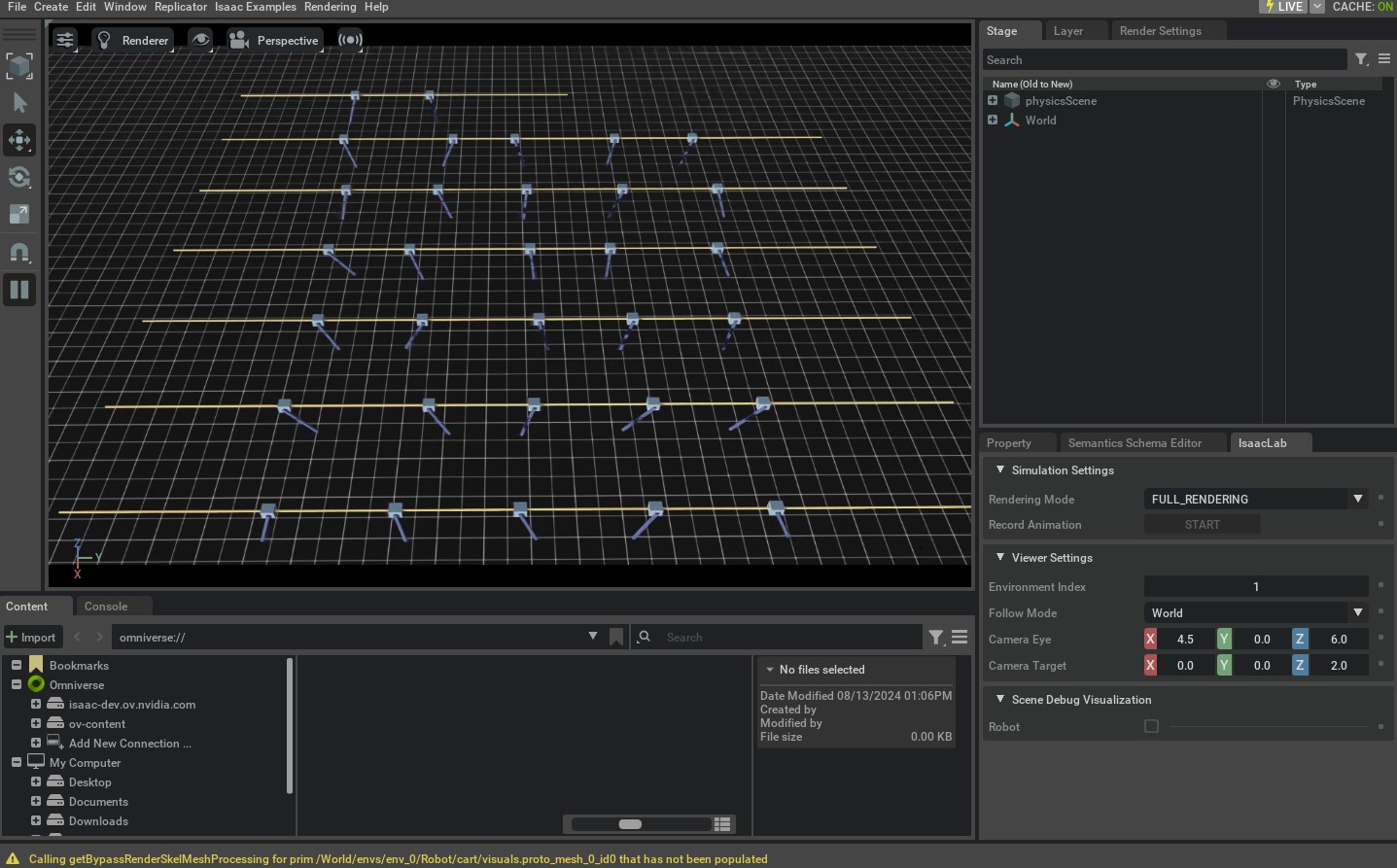

这会打开一个具有地平面、光源和cartpoles的场景。仿真应该正在进行中,并对cartpole进行随机动作。此外,它还在屏幕右下角打开一个名为 "Isaac Lab" 的UI窗口。此窗口包含不同的UI元素,可用于调试和可视化。

要停止仿真,可以关闭窗口,或在启动仿真的终端中按 Ctrl+C 。

在这个教程中,我们学习了不同的管理器,来帮助定义基础环境。我们还在 scripts/tutorials/03_envs 目录中包含了更多定义基础环境的示例。为了完整起见,可以使用以下命令来运行它们:

# Floating cube environment with custom action term for PD control

./isaaclab.sh -p scripts/tutorials/03_envs/create_cube_base_env.py --num_envs 32

# Quadrupedal locomotion environment with a policy that interacts with the environment

./isaaclab.sh -p scripts/tutorials/03_envs/create_quadruped_base_env.py --num_envs 32

在接下来的教程中,我们将看看 envs.ManagerBasedRLEnv 类以及如何使用它来创建马尔可夫决策过程(MDP)。